即可将网页分享至朋友圈

近日,信息与软件工程学院田文洪教授团队在计算语言学协会北美分会Annual Conference of the North American Chapter of the Association for Computational Linguistics(NAACL)2024会议上发表针对人工智能大语言模型在产业应用上进行无损推理加速的学术论文。NAACL是世界学术界和企业界公认的自然语言领域的顶级会议之一,自然语言领域的众多里程碑式的成果都曾在该会议上进行发表,入选的科研论文代表着当前的国际水平。

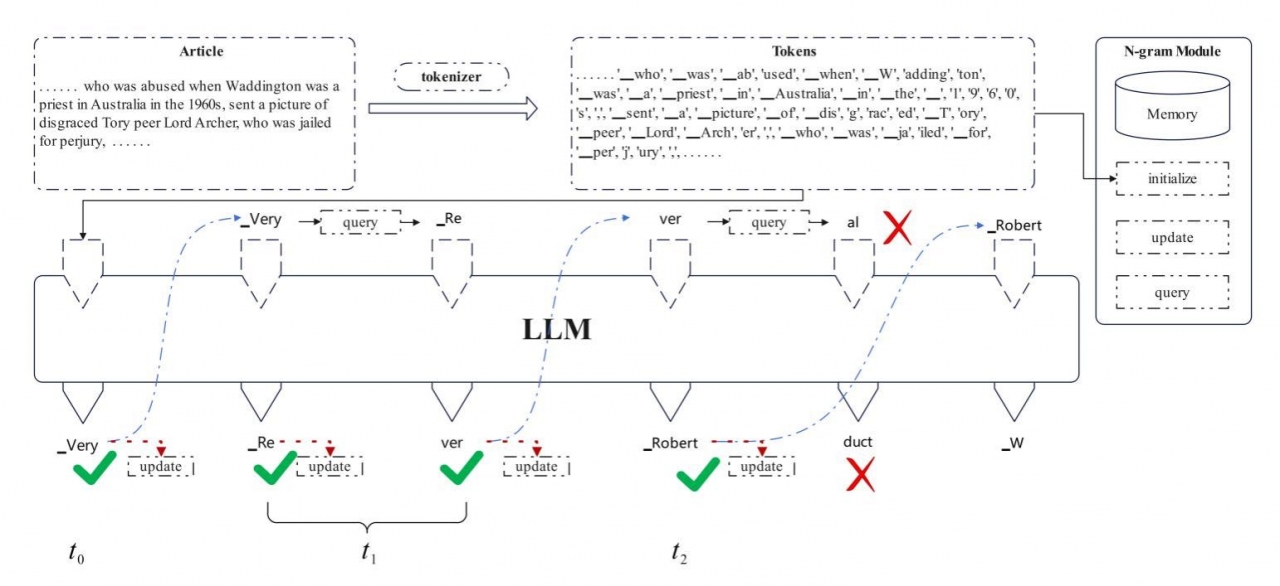

该研究提出了一种无损名为“Adaptive N-gram Parallel Decoding”(自适应N-gram并行解码)的创新算法,通过允许同时生成多个令牌来加速大型语言模型的推理过程。众所周知,尽管大型语言模型展现出了非凡的能力,但由于自回归处理,它们常常受到显著的资源消耗和相当大的延迟的阻碍。Adaptive N-gram Parallel Decoding采用了一种两阶段的方法:首先是一个快速起草阶段,该阶段使用一个基于当前交互上下文自适应的N-gram模块;然后是验证阶段,在此阶段,原始的大型语言模型评估并确认提议的令牌。通过这种方式,Adaptive N-gram Parallel Decoding在提高处理速度的同时,保留了大型语言模型原始输出的完整性。该研究还利用了N-gram模块的多级架构来提高初始草稿的精确度,从而进一步减少了推理延迟。值得注意的是,Adaptive N-gram Parallel Decoding消除了重新训练或额外GPU内存的需求,使其成为一种高效且即插即用的增强方法。在该研究的实验对比分析中,相比LLaMA及其微调变体等模型的速度提升高达3.67倍,这一结果有力地验证了Adaptive N-gram Parallel Decoding的有效性。这项突破性的研究为加速大型语言模型的推理过程提供了一种全新的思路,有望在自然语言处理领域产生较深远的影响。

图 大语言模型无损推理加速方法架构图

信息与软件工程学院特色化先进计算实验室 (Advanced Computing Lab, ACL)致力于基于先进计算(云计算、大数据、人工智能等方面)的创新理论研究和与实践相结合的研究路线,核心定位立足于先进智能技术、工业软件、大健康等国计民生关键技术领域和行业,以解决重大社会需求为牵引,实现理论创新、技术突破、产品研发与行业成果转化的政研学用紧密结合。团队共有14名教师成员,具有海外博士学位的教师4名,包括正高3人、博导 3人、副教授 7人、讲师4人,在读博士后、博士、硕士研究生百余人。

编辑:刘瑶 / 审核:李果 / 发布:陈伟